Por Aurora Apolito

3. A auto-organização em redes e o problema da escala no anarquismo

Não estou tentando apresentar uma solução definitiva para o problema da escala, mas esclarecer importantes aspectos que podem nos levar, espero, a uma elaboração mais precisa do problema. Esta seção será um pouco mais técnica, na medida em que analisarei alguns métodos de análise de redes complexas, que acho que devem ser encarados como ferramentas necessárias para abordar o problema da escala numa perspectiva anarquista.

Uma premissa fundamental, para elaborar mais precisamente o problema da escala no anarquismo, é que o anarquismo é essencialmente um processo de auto-organização em redes complexas. O fenômeno da auto-organização em redes é amplamente estudado na teoria dos sistemas complexos, impulsionada por um conjunto de modelos, dos sistemas de telecomunicações à neurociência. Contudo, o que precisamos desenvolver vai além de uma reformulação ou de uma aplicação direta desses modelos. O que eu gostaria de esboçar aqui é uma breve síntese daquilo que considero os aspectos mais complicados e cruciais do problema.

Ludwig von Mises, em seu conhecido ensaio de 1920, defendendo os mercados contra a tendência acelerada rumo ao planejamento econômico socialista, buscava apresentá-los como um dispositivo computacional eficiente. Como discutido num ensaio introdutório em [9], “A provocação que Mises fazia ao socialismo era decididamente tecnocrática: apresentar uma infraestrutura computacional alternativa que pudesse competir com o sistema de preços […] Foi uma provocação da qual poucos socialistas foram capazes de se esquivar, e menos ainda foram capazes de enfrentar”.

A lacuna no desenvolvimento de uma tal “infraestrutura socialista alternativa de computação” é realmente lamentável. Contudo, para sermos honestos, é bem possível que a matemática necessária para apresentar uma resposta socialista/comunista viável para a provocação de Mises simplesmente não estivesse disponível na época, e por muito tempo depois disso. Mesmo quando das tentativas de implementar formas de comunismo cibernético, nos anos 60 e no início dos anos 70, a teoria das redes complexas estava ainda na infância. É provável que, embora tivessem a ideia geral correta na cabeça, os esforços de Victor Glushkov e Stafford Beer falhassem ao serem implementados nas condições científicas e tecnológicas da época, simplesmente porque a capacidade de processamento de informações era ainda muito baixa e alguns instrumentos matemáticos cruciais não estavam ainda à disposição. Estamos hoje numa posição muito melhor para apresentar uma alternativa viável aos mercados, então não há mais desculpas para fugir do problema.

A discussão que faço nesta seção deve ser entendida como um exercício ao estilo “Economic Science Fictions”, como aqueles discutidos com profundidade em [9], e como um exercício de imaginação matemática, como mencionamos acima. O objetivo é conceber a forma matemática de uma infraestrutura comunista cibernética de computação capaz de substituir o mecanismo de otimização de lucros do mercado.

3.1. Complexidade. Antes de mais nada, a complexidade é a noção fundamental aqui, mas é também uma noção muito sutil, difícil de precisar. A principal definição de complexidade na matemática é a complexidade de Kolmogorov, que define a complexidade de alguma coisa como o tamanho do menor processo (algoritmo) que a realiza [23]. Nomeadamente,

\begin{equation} \mathcal{K}(x)=\min \limits _{P}\left \{\ell (P) \mid T_{U}(P)=x\right \} \end{equation}

o que significa que a complexidade de \( x \) é o tamanho mínimo \( \ell (P) \) de todos os programas \( P \) que, executados num computador universal \( T_{U} \) (máquina de Turing), produzirão o resultado \( x \). Faço esse esclarecimento porque facilita a comparação com outras definições, e porque também farei menções à “complexidade relativa”, ao que retornarei adiante. Ela é obtida por

\begin{equation} \mathcal{K}(x \mid y)=\min \limits _{P}\left \{\ell (P) \mid T_{U}(P, y)=x\right \} \end{equation}

que é a mesma coisa, porém o computador \( T_{U} \) é autorizado a usar a entrada \( y \) no programa \( P \) para computar \( x \).

A complexidade de Kolmogorov é em si uma função não computável, porque o “problema da parada”, que determina se um programa continuará rodando para sempre ou parará a certa altura, com determinado resultado, é em si mesmo um problema indecidível. Surpreendentemente, a não computabilidade em si não é um obstáculo sério porque a complexidade de Kolmogorov possui vários limites superiores perfeitamente computáveis (por qualquer algoritmo de compressão), o que significa que não pode ser calculada, mas pode ser estimada por excesso, de maneira computável. Há, no entanto, outra desvantagem mais séria no uso da complexidade de Kolmogorov: ela não corresponde à noção intuitiva de complexidade que desejamos modelar, visto que, embora atribua corretamente baixa complexidade a padrões facilmente previsíveis, confere, por outro lado, complexidade máxima a padrões completamente aleatórios. Maximizar a aleatoriedade não é, claro, o resultado desejado, independentemente da concepção ingênua de anarquismo que possa estar circulando na esquerda. A entropia de Shannon assemelha-se à versão moderada da complexidade de Kolmogorov,

\begin{equation*} H(\mathbb{E})=-\sum _{x} \mathbb{E}(x) \log \mathbb{E}(x) \sim \sum _{x} \mathbb{E}(x) \mathcal{K}(x \mid \mathbb{E}) \end{equation*}

e tem a mesma tendência para detectar aleatoriedades, portanto, em si mesma, também não ajuda.

Existem formas de conceber medidas de complexidade mais voltadas para detectar a “complexidade estruturada”, em vez da complexidade oriunda da imprevisibilidade da aleatoriedade. Uma primeira modificação possível na complexidade de Kolmogorov, capaz de captar melhor uma forma de “complexidade organizada”, é dada pela profundidade lógica. Essa noção foi introduzida em [3], usando o tempo de execução de um programa quase mínimo em vez do tamanho do programa mínimo, como no caso de Kolmogorov. Ou seja,

\begin{equation} \mathcal{D}_{\alpha }(x)=\min \limits _{P}\left \{\tau (P) \mid \ell (P)-\mathcal{K}(x) \leq \alpha , T_{U}(P)=x\right \} \end{equation}

o que significa computar o tempo mínimo de execução de um programa \( P \) que gera \( x \), cujo tamanho é igual ou apenas um pouco maior que o mínimo (cujo tamanho é \( \mathcal{K}(x) \)). A discrepância permitida entre o tamanho mínimo \( \mathcal{K}(x) \) e \( \ell (P) \) é medida por um parâmetro variável \( \alpha \) . (Mais precisamente, uma forma ligeiramente diferente da complexidade Kolmogorov \( \mathcal{K}(x) \) é usada em (3), mas não vou entrar em detalhes aqui: eles podem ser encontrados em [2].) Passar do mínimo para o quase mínimo serve para evitar que alguns programas um pouco maiores possam ter um tempo de execução menor. Mais interessante ainda, passar do tamanho de um programa para seu tempo de execução pode parecer, a princípio, uma mudança ínfima, já que o tempo de execução pode ser visto como outra modalidade de tamanho (no tempo, não na memória), mas produz um efeito significativo na redução do papel da aleatoriedade em padrões de alta complexidade. Uma análise comparativa da complexidade de Kolmogorov e da profundidade lógica pode ser encontrada em [10]. A razão pela qual não quero usar essa simples modificação da complexidade de Kolmogorov reside num fenômeno de “transição de fase” descrito em [2], que mencionarei em seguida, o que dificulta o uso da profundidade lógica como base para a construção de uma função de otimização.

Murray Gell-Mann propôs uma noção de “complexidade efetiva” e uma noção de “complexidade potencial” [11], com o objetivo de captar mais adequadamente nossa noção intuitiva da complexidade como um fenômeno altamente estruturado. A complexidade efetiva serve para obter o conteúdo de informação das “regularidades” de um padrão, enquanto a complexidade potencial é uma noção semelhante que serve para incorporar as mudanças no tempo. Uma primeira descrição matemática da complexidade efetiva foi apresentada em [12]. Infelizmente, nenhuma dessas noções possui ainda um formalismo matemático completamente bem desenvolvido. Podemos, no entanto, partir do estágio atual, no que diz respeito às noções mais promissoras de complexidade, e ver o que podemos fazer com elas.

Uma boa síntese sobre o atual estágio dessas medidas de complexidade encontra-se em [2], estudo que será referido a seguir. Para obter uma descrição apropriada da complexidade efetiva, consideremos uma combinação entre a complexidade de Kolmogorov e a entropia de Shannon, denominada “informação total” \( \mathcal{K}(\mathbb{E})+H(\mathbb{E}) \). Ela pode ser descrita como a complexidade algorítmica de \( x \) (a parte de Kolmorogorov \( \mathcal{K}(x \mid \mathbb{E}) \)) ao computarmos o conjunto estatístico \( \mathbb{E} \) ao qual \( x \) pertence (a parte de Shannon \( H(\mathbb{E}) \)). O melhor conjunto estatístico \( \mathbb{E} \) para dado \( x \) é aquele que minimiza a informação total, o que é outra maneira de dizer que trata-se da explicação mais provável para dado \( x \). Tendo sido selecionado o modelo estatístico \( \mathbb{E} \) adequado, podemos detectar se o elemento \( x \) é “típico” nesse conjunto estatístico verificando se a probabilidade \( \mathbb{E}(x) \) não é muito menor que o tamanho médio \( 2^{}{-H(\mathbb{E})} \), previsto pela entropia de Shannon. Dado \( x \), é possível selecionar, assim, o conjunto \( \mathcal{M}_{x}\) de todos os conjuntos estatísticos possíveis \( \mathbb{E} \) com pequena informação total e para o qual \( x \) é típico (possivelmente com restrições adicionais no que se refere ao conjunto de “boas teorias” que pretendemos considerar). A “complexidade efetiva” \( \mathcal{E}(x) \) é o valor mínimo da complexidade de Kolmogorov \( \mathcal{K}(\mathbb{E}) \) entre todos os conjuntos concorrentes \( \mathbb{E} \),

\begin{equation} \mathcal{E}(x)=\min \limits _{\mathrm{E} \in \mathcal{M}_{x}} \mathcal{K}(\mathbb{E}) \end{equation}

Observe que estamos definindo complexidade efetiva aqui como um mínimo de complexidade de Kolmogorov em relação a um certo conjunto de modelos estatísticos \( \mathbb{E} \) que explica dado \( x \), o que significa que queremos selecionar a explicação mais simples, de um conjunto de teorias plausíveis. Isso parece contradizer o que mencionei anteriormente, a saber, que buscamos uma maximização da complexidade informacional. No entanto, essa maximização ainda está por vir: a minimização que acabei de descrever é simplesmente uma etapa preliminar necessária que atribui um valor de complexidade apropriado a um dado.

O que ganhamos usando a complexidade efetiva \( \mathcal{E}(x) \) em vez da complexidade de Kolmogorov \( \mathcal{K}(x) \) ou da entropia de Shannon \( H(\mathbb{E}) \)? A principal vantagem é que agora padrões completamente aleatórios têm pequena complexidade efetiva! Portanto, objetos com grande complexidade efetiva são gerados por “complexidade estruturada”, e não por aleatoriedade. Não é imediatamente óbvio que a complexidade efetiva de padrões aleatórios seja pequena: uma prova desse fato é dada, por exemplo, no Teorema 10 de [2], enquanto alguns casos de padrões não aleatórios que exibem grande complexidade efetiva são descritos no Teorema 14 de [2].

O fenômeno de “transição de fase” mencionado acima para o comportamento da profundidade lógica é baseado em como \( \mathcal{D}_{\alpha }(x) \) muda em comparação com a complexidade efetiva \( \mathcal{E}(x) \). É possível demonstrar (veja o Teorema 18 de [2] para mais detalhes) que, para pequenos valores de \( \mathcal{E}(x) \), a complexidade lógica também pode assumir pequenos valores, mas quando a complexidade efetiva cruza um valor limite (que depende da complexidade de Kolmogorov), a profundidade lógica salta repentinamente para valores muito grandes. Essa transição de fase repentina no comportamento de \( \mathcal{D}_{\alpha }(x) \) torna seu uso inconveniente para nossos objetivos, enquanto a complexidade efetiva \( \mathcal{E}(x) \) é mais adequada.

No caso da entropia de Shannon, há uma versão relativa semelhante que mede a discrepância informacional entre dois modelos estatísticos, a saber, a divergência de Kullback-Leibler

\begin{equation} \mathrm{KL}(\mathbb{E}, \mathbb{P})=\sum _{x} \mathbb{E}(x) \log \left (\frac{\mathbb{E}(x)}{\mathbb{P}(x)}\right ) \end{equation}

Em termos bayesianos, ela mede a informação obtida ao se passar da probabilidade prévia \( \mathbb{P} \) para a posterior \( \mathbb{E} \). A complexidade relativa de Kolmogorov (2) pode ser usada, de modo semelhante, como uma forma de distância da informação [4]. É possível construir, usando a complexidade relativa de Kolmogorov, uma noção parecida de complexidade efetiva relativa, \( \mathcal{E}(x \mid y) \), que também pode ser vista como uma medida de perda/ganho na complexidade informacional.

Então, digamos que algo como \( \mathcal{E}(x \mid y) \) forneça uma medida que leva em consideração se a complexidade informacional é aumentada ou diminuída por um processo que transforma um estado \( y \) anteriormente ocupado pelo sistema em um novo estado dado por \( x \). E então? Ainda precisamos ver como isso se relaciona com as redes e sua estrutura de pequena e grande escala.

3.2. Uma ideia da neurociência. Os anarquistas são tradicionalmente avessos à noção comunista de coletividade, contrastando-a geralmente com variados graus de individualismo. A palavra “coletivismo” lembra (com razão) as coletivizações forçadas do stalinismo e a supressão da agência individual. Por outro lado, a palavra “individualismo” constitui facilmente um espantalho para os comunistas, evocando algo como uma combinação linear convexa entre J. D. Salinger e Ayn Rand, concorrendo com os abutres neoliberais no que se refere ao medo e à supressão da agência coletiva. Essa não é, absolutamente, uma abordagem produtiva. A pergunta verdadeiramente importante que devemos fazer é que tipo de “coletividade” maximiza por toda parte a agência individual, ao mesmo tempo em que torna as estruturas coletivas possíveis e interessantes (no sentido da complexidade informacional mencionada anteriormente). Analisarei essa questão à luz de ideias recentemente desenvolvidas no contexto da neurociência, da modelagem de redes cerebrais e da teoria da consciência.

Uma esforço considerável de compreensão da estrutura de redes complexas veio da neurociência. Uma ideia que parece especialmente relevante para o que estamos tentando modelar aqui é a noção de informação integrada, que foi originalmente proposta em [33] como um modelo quantitativo de consciência. Um panorama geral dessa ideia é apresentado em [20] [25].

A ideia central é que a informação integrada mede a quantidade de complexidade informacional em um sistema que não pode ser reduzido separadamente às suas partes individuais. É um modo de explicar quão ricas são as possibilidades de inter-relação causal entre diferentes partes do sistema.

Um modo de expressar essa ideia com mais precisão foi desenvolvido em [30]. Consideram-se todas as formas possíveis de dividir um determinado sistema em subsistemas (uma rede em sub-redes locais, por exemplo). Para cada partição \( \lambda \), considera-se o estado do sistema num determinado momento \( t \), conforme descrito por um conjunto de observáveis \( X_{t} \), e o estado em um tempo futuro próximo \( X_{t+1} \). A partição \( \lambda \) em \( N \) subsistemas corresponde a uma divisão dessas variáveis \( X_{t}=\left \{X_{t, 1}, \ldots , X_{t,N}\right \} \) e \( X_{t+1}=\left \{X_{t+1,1}, \ldots , X_{t+1, N}\right \} \), em variáveis que descrevem os subsistemas. Todas as relações causais entre os \( X_{t, i} \), ou entre os \( X_{t+1, j} \), bem como a influência causal dos \( X_{t, i} \) sobre os \( X_{t+1, j} \) através da evolução temporal do sistema, são obtidas (estatisticamente) pela distribuição de probabilidade conjunta \( \mathbb{P}\left (X_{t+1}, X_{t}\right ) \). Para obter a informação integrada do sistema, compara-se o conteúdo da informação dessa distribuição conjunta com o das distribuições em que as únicas dependências causais entre \( X_{t+1} \) e \( X_{t} \) ocorrem através da evolução em cada subsistema separado, mas não entre subsistemas, o que significa distribuições de probabilidade \( \mathbb{Q}\left (X_{t+1}, X_{t}\right ) \), com a propriedade de que \( \mathbb{Q}\left (X_{t+1, i} \mid X_{t}\right )=\mathbb{Q}\left (X_{t+1, i} \mid X_{t, i}\right ) \), para cada subconjunto \( i=1, \ldots , N \) da partição. Vamos chamar \( \mathcal{M}_{\lambda } \) o conjunto de distribuições de probabilidade \( \mathbb{Q}\left (X_{t+1}, X_{t}\right ) \) com essa propriedade em relação à partição \( \lambda \). Então obtém-se a informação integrada \( \phi \) do sistema ao se minimizar a divergência Kullback-Leibler (5) entre: a) o sistema atual; e b) sua melhor aproximação por probabilidades que implementam a desconexão causal entre os subsistemas e a avaliação na partição de informação mínima (isto é, minimização sobre a escolha de partição).

\begin{equation} \Phi =\min \limits _{\lambda } \min \limits _{\mathbb{Q} \in \mathcal{M}_{\lambda }} \mathrm{KL}\left (\mathbb{P}\left (X_{t+1}, X_{t}\right ) \| \mathbb{Q}\left (X_{t+1}, X_{t}\right )\right ) \end{equation}

O valor \( \phi \) obtido dessa maneira representa a informação adicional em todo o sistema que não é, de modo algum, redutível às partes menores. É a forma de expressar o conceito de “holístico” em termos informacionais.

Já que estamos mais interessados na complexidade efetiva do que em medidas informacionais, como a divergência de Kullback-Leibler, é possível desenvolver uma versão da informação integrada em que a discrepância entre o sistema e sua desconexão causal nos subsistemas é medida por uma complexidade efetiva relativa (como discutido acima) e não pela divergência de Kullback-Leibler (detalhes em outra parte: esta não é a ocasião para provar novos teoremas).

Detalhes à parte, o que buscamos aqui é fornecer uma medida viável para um processo de otimização. Maximizar informação integrada (em uma versão de complexidade efetiva) significaria obter um sistema que realize a máxima integração possível da complexidade informacional em todos os subsistemas possíveis e o mais alto grau de interconectividade causal dos subsistemas.

É possível perceber por que isso faz exatamente o que estamos procurando. Maximizar nossa informação integrada \( \phi \) favorece a cooperação em lugar da concorrência, uma vez que a concorrência tende a dividir um sistema em competidores separados e isso diminui a função \( \phi \), enquanto a cooperação aumenta a conectividade e amplia a rede de influências causais mútuas, aumentando \( \phi \). Além disso, um mecanismo capaz de maximizar \( \phi \) eliminaria fenômenos repugnantes como a propriedade intelectual, já que manter o conhecimento inacessível diminui sua conectividade causal, reduzindo o valor geral de \( \phi \). Aumentar \( \phi \) é, em vez disso, compatível com o compartilhamento do conhecimento, redes P2P etc. Aumentar \( \phi \) não leva à acumulação capitalista de riqueza, uma vez que a concentração de riqueza e recursos tende a separar certos subsistemas e a diminuir sua influência causal mútua com o restante dos subsistemas de rede, e isso reduziria a integração geral da complexidade informacional em todo o sistema. A informação integrada é, por definição, uma “coletividade” porque é exatamente a quantidade de complexidade informacional que reside no coletivo sem estar localizada em nenhum subsistema individual separadamente. Por outro lado, é uma coletividade que maximiza a agência individual porque maximiza o grau de influência causal e, portanto, de possível agência, de cada subsistema individual.

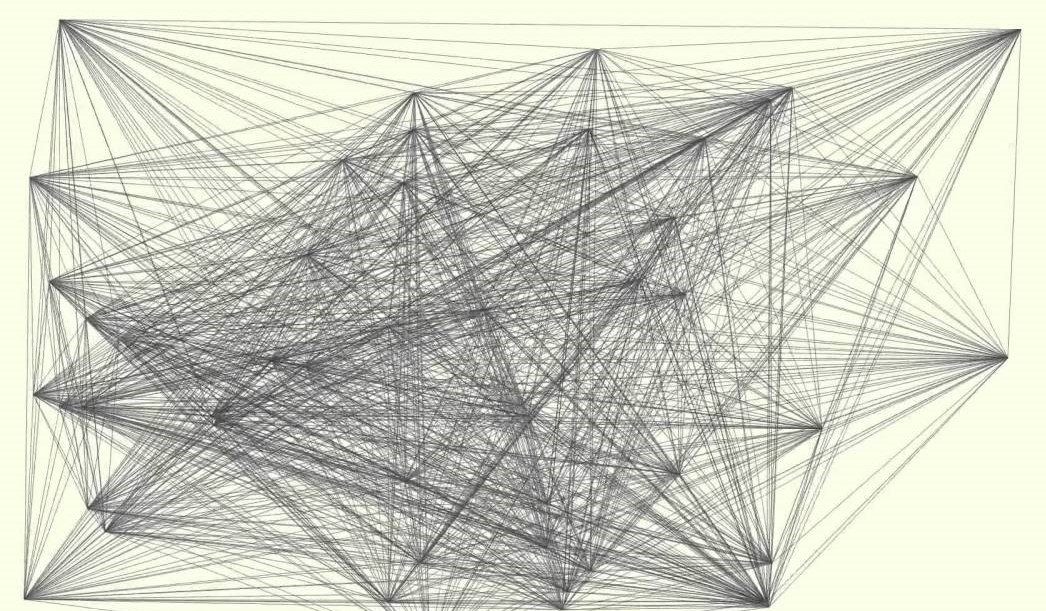

Este artigo está ilustrado com obras de Sol LeWitt (1928-2007).

Este artigo está ilustrado com obras de Sol LeWitt (1928-2007).

Traduzido pelo Passa Palavra.

Este artigo será publicado em quatro partes, uma por semana. Leia aqui a 1a, a 2a e a 4a parte.

Referências

[1] Allan Antliff, Anarchist Modernism, University of Chicago Press, 2007.

[2] Nihat Ay, Markus Mueller, Arleta Szkola, Effective complexity and its relation to logical depth, IEEE Trans. Inf. Th., Vol. 56/9 (2010) 4593–4607. [arXiv:0810.5663]

[3] Charles H. Bennett, Logical Depth and Physical Complexity, in “The Universal Turing Machine – a Half-Century Survey” (Ed. Rolf Herken), Oxford University Press, 1988.

[4] Charles H. Bennett, Peter Gács, Ming Li, Paul M.B. Vitányi, Wojciech H. Zurek, Information distance, IEEE Transactions on Information Theory, 44(1998) N.4, 1407–1423.

[5] Franco ‘Bifo’ Berardi, The Uprising: On Poetry and Finance, Semiotext(e), 2012.

[6] Franco ‘Bifo’ Berardi, Breathing: Chaos and Poetry, Semiotext(e), 2019.

[7] Ginestra Bianconi, Multilayer Networks, Oxford University Press, 2018.

[8] John E. Bowlt and Olga Matich, eds., Laboratory of Dreams: The Russian Avant-garde and Cultural Experiment, Stanford University Press, 1996.

[9] William Davies (Ed.), Economic Science Fictions, Goldsmiths Press, 2019.

[10] Jean-Paul Delahaye, Complexité aléatoire et complexité organisée, Editions Quae, 2009.

[11] Murray Gell-Mann, What is Complexity? Complexity, Vol.1 (1995) N.1 [9 pages].

[12] Murray Gell-Mann, Seth Lloyd, Information Measures, Effective Complexity, and Total Information, Complexity, Vol. 2 (1996) 44–52.

[13] Slava Gerovitch, From Newspeak to Cyberspeak. A History of Soviet Cybernetics, MIT Press, 2002.

[14] George Gorelik, Bogdanov’s Tektology, General Systems Theory, and Cybernetics, Hemisphere Publishing, 1987.

[15] Nina Gourianova, The Aesthetics of Anarchy: Art and Ideology in the Early Russian Avant-Garde, University of California Press, 2012.

[16] Simon Ings, Stalin and the Scientists: A History of Triumph and Tragedy, 1905–1953, Open Road & Grove Atlantic, 2017.

[17] Annamma Joy, John F. Sherry, Jr., Disentangling the paradoxical alliances between art market and art world, Consumption, Markets & Culture, Vol.6 (2003), N.3, 155–181.

[18] Leonid Vitaliyevich Kantorovich, Mathematical methods of organization and planning of production, Leningrad State University Press, 1939.

[19] Anatoly Kitov, Aleksei Lyapunov, Sergei Sobolev, The Main Features of Cybernetics, Voprosy filosofii (Problems of Philosophy), No. 4 (1955), 136–148.

[20] Christoph Koch, The feeling of life itself, MIT Press, 2019.

[21] Nikolai Krementsov, A Martian Stranded on Earth: Alexander Bogdanov, Blood Transfusions, and Proletarian Science, The University of Chicago Press, 2011.

[22] David A. Lax, Libermanism and the Kosygin reform, University of Virginia Press, 1991.

[23] Ming Li, Paul Vitányi, An Introduction to Kolmogorov Complexity and Its Applications, Springer, 1997 [New Edition, 2008].

[24] Evsei G. Liberman, Plans, Profits, and Bonuses, Pravda, September 9, 1962.

[25] Marcello Massimini, Giulio Tononi, Sizing up consciousness, Oxford University Press, 2018.

[26] Warren S. McCulloch, A Heterarchy of Values Determines by the Topology of Nervous Nets, Bulletin of Mathematical Biophysics, 7 (1945) 89–93.

[27] Eden Medina, Cybernetic Revolutionaries. Technology and Politics in Allende’s Chile, MIT Press, 2011.

[28] Benjamin Peters, How Not to Network a Nation. The Uneasy History of the Soviet Internet, MIT Press, 2016. [29] Ethan Pollock, Stalin and the Soviet Science Wars, Princeton University Press, 2006.

[30] M. Oizumi, N. Tsuchiya, S. Amari, Unified framework for information integration based on information geometry, PNAS, Vol. 113 (2016) N. 51, 14817–14822.

[31] Jaeweon Shin, Michael Holton Price, David H. Wolpert, Hajime Shimao, Brendan Tracey, Timothy A. Kohler, Scale and information-processing thresholds in Holocene social evolution, Nature Communications (2020) 11:2394

[32] Higor Y. D. Sigaki, Matjaž Perc, Haroldo V. Ribeiro, History of art paintings through the lens of entropy and complexity, PNAS, Vol.115 (2018) N.37, E8585–E8594

[33] G. Tononi G (2008) Consciousness as integrated information: A provisional manifesto, Biol. Bull. 215 (2008) N.3, 216–242.

[34] Anatoly Vershik, L.V.Kantorovich and Linear Programming, arXiv:0707.0491.

[35] Norbert Wiener, Cybernetics, or control and communication in the animal and the machine, MIT Press, 1948.

Resumo da ópera: “Quem não pode com mandinga não carrega patuá.”

HIPÓTESE: Mandinga como pseudônimo de superstição tecnólatra e patuá, vulgo caixa de ferramentas, impregnado de algoritmos transgodelianos.

Excelente série!!! Enquanto o anarquismo ignorar os desafios econômicos em seu projeto de sociedade igualitária e descentralizada, continuará sendo um movimento meramente marginal, visto como infantil por parte da esquerda e como utópico pelo senso comum. Essa utilização das teorias da complexidade e de todo seu potencial matemático precisa ser urgentemente apropriado e desenvolvido pelos libertários, pois, como alguém disse uma vez, derrubar um sistema não é assim tão difícil… o problema é segurar o rojão depois. Ou seja, apresentar uma alternativa revolucionária concreta e viável com vistas a superar o capitalismo, sem cairmos no erro crasso das visões estatizantes de um lado e nem do mero espontaneísmo por outro (o que apenas levaria à restauração da ordem capitalista).